2026-02-11 14:26:13来源: 网络作者:admin

DeepSeek的研究人员研发出一种技术,能让大型语言模型的训练过程更趋稳定。此方法借助数学约束,来应对扩展网络架构时存在的一个广为人知的难题。

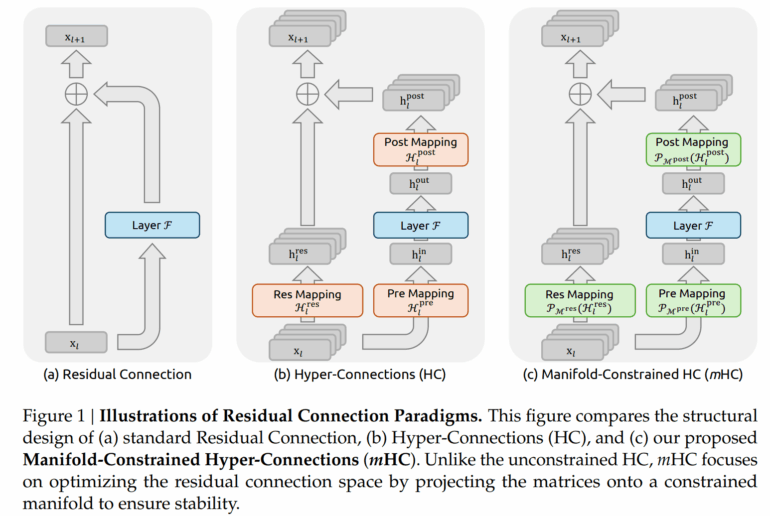

神经网络在近十年间一直借助残余连接,实现深度架构中的信息传递。这类连接可被视为捷径——早期层的信息能直接输送至后续层,从而让训练过程更为稳定。而像“超连接”(HC)这样的新方法,则在这一核心原则上进一步拓展了信息流,构建起更复杂的连接模式。

研究人员表示,核心问题在于:尽管这类扩展对性能有所提升,却导致大型模型的训练过程变得不稳定。为此,DeepSeek团队推出了名为“多流受限超连接”(mHC)的方案,其目标是同时兼顾性能提升与训练稳定这两方面的优势。

免责声明:文章图片应用自网络,如有侵权请联系删除